El gigante tecnológico Alibaba ha sorprendido a la comunidad global con el lanzamiento de QwQ-32B, un modelo de lenguaje de gran tamaño (LLM) de código abierto diseñado para competir directamente con titanes de la industria como DeepSeek.

Alibaba ha lanzado QwQ-32B, un modelo de IA que desafía el status quo de los modelos de IA existentes.

Este nuevo modelo de IA se presenta como un faro de innovación en el panorama de la IA, destacando por su arquitectura optimizada y un conjunto de características que le permiten competir de tú a tú con modelos de mucha mayor envergadura.

Según Alibaba, su nuevo modelo se basa en una arquitectura Transformer, un estándar de la industria ampliamente reconocido por su capacidad para procesar y generar texto de manera eficiente. La compañía ha implementado mejoras significativas en esta arquitectura, optimizando la eficiencia computacional y la precisión del modelo, por lo que QwQ-32B, con apenas 32.500 millones de parámetros, logra rendimientos comparables a modelos mucho más grandes, como DeepSeek R1.

IR A BIT2ME CARDEl tamaño del modelo QwQ-32B es considerablemente menor que el tamaño de otros modelos líderes en el mercado, algunos de los cuales superan los cientos de miles de millones de parámetros. A pesar de esta diferencia, QwQ-32B demuestra un rendimiento sorprendente, comparable e incluso superior en algunas tareas específicas, como comprensión del lenguaje, generación de texto, razonamiento y traducción. Los resultados demuestran que QwQ-32B supera a otros modelos de tamaño similar y se acerca al rendimiento de modelos mucho más grandes, como algunos de los ofrecidos por OpenAI y Google.

QwQ-32B: Eficiencia sin sacrificar rendimiento

Además de su rendimiento en benchmarks estandarizados, QwQ-32B también ha demostrado ser útil en aplicaciones del mundo real. Alibaba ha utilizado el modelo internamente para mejorar sus servicios de búsqueda, traducción y atención al cliente. También se ha puesto a disposición de la comunidad de desarrolladores para que puedan experimentar con él y desarrollar nuevas aplicaciones.

Profundizando en las características que hacen destacar a QwQ-32B, es crucial examinar su capacidad para gestionar grandes volúmenes de datos y su adaptabilidad a diferentes tareas. La arquitectura optimizada del modelo permite un procesamiento más rápido y eficiente, reduciendo los costos computacionales asociados con el entrenamiento y la implementación. Además, su rendimiento competitivo en relación con modelos mucho más grandes sugiere que QwQ-32B podría ser una opción viable para organizaciones con recursos limitados. La capacidad de QwQ-32B para mejorar los servicios de búsqueda, traducción y atención al cliente de Alibaba destaca su versatilidad y potencial para transformar diversas industrias.

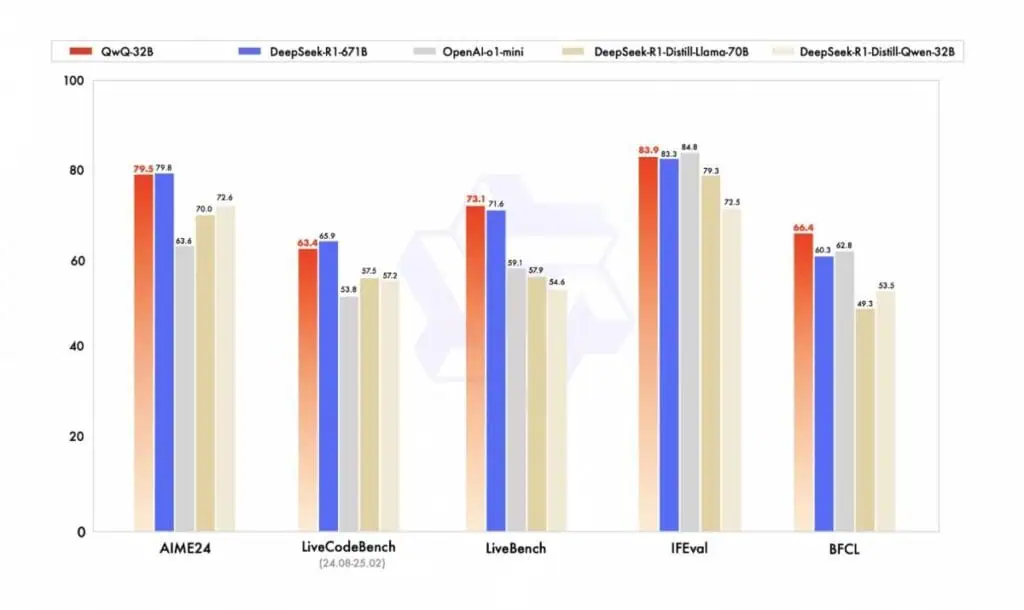

INVITA Y GANADe acuerdo con la compañía, QwQ-32B “sobresale en una variedad de puntos de referencia, incluidos AIME 24 (razonamiento matemático), Live CodeBench (competencia en codificación), LiveBench (contaminación de conjuntos de prueba y evaluación objetiva), IFEval (capacidad de seguimiento de instrucciones) y BFCL (capacidades de llamada a herramientas y funciones)”.

Fuente: Alibaba Cloud

Estos resultados destacan la efectividad del enfoque de Alibaba en combinar modelos preentrenados robustos con técnicas de entrenamiento avanzadas. Además, QwQ-32B ha demostrado ser capaz de seguir instrucciones de manera efectiva y adaptarse a preferencias humanas, lo que lo hace útil para una variedad de aplicaciones.

El desarrollo y entrenamiento de QwQ-32B

QwQ-32B es el resultado de un enfoque innovador en el diseño y entrenamiento de modelos de IA. Aunque cuenta con solo 32.500 millones de parámetros, su arquitectura y las técnicas utilizadas durante su desarrollo le permiten rivalizar con modelos considerablemente más grandes.

Uno de los factores clave detrás de su éxito es el uso de Aprendizaje por Refuerzo (RL), una técnica que ha demostrado ser fundamental para mejorar las capacidades de razonamiento de los modelos de IA. Según el equipo de Alibaba, QwQ-32B fue entrenado utilizando recompensas de un modelo de recompensa general y verificadores basados en reglas, lo que mejoró significativamente sus habilidades en tareas como el razonamiento matemático y la codificación.

Además, QwQ-32B se basa en Qwen2.5-32B, un modelo preentrenado con un amplio conocimiento del mundo real, lo que le proporciona una base sólida para sus capacidades. Este enfoque ha permitido que el modelo no solo sea eficiente, sino también altamente competitivo en comparación con otros modelos de IA de última generación.

ENLAZA CARD Y EARNDemocratizando el acceso a la IA

Con el lanzamiento de QwQ-32B, Alibaba busca democratizar el acceso a esta innovación. La compañía ha dicho que su nuevo modelo está disponible como modelo de código abierto en Hugging Face y Model Scope bajo la licencia Apache 2.0, lo que permite descargas gratuitas. Esto significa que cualquier desarrollador o empresa puede acceder y utilizar el modelo, facilitando su integración en aplicaciones de terceros.

Además, al proporcionar un modelo de IA avanzado que no requiere recursos computacionales masivos, Alibaba está contribuyendo a democratizar el acceso a tecnologías de vanguardia. Esto no solo fomenta la innovación, sino que también reduce la brecha entre los grandes actores de la industria y los más pequeños.

Por otro lado, aunque QwQ-32B representa un avance significativo en la IA, no está exento de desafíos. Una de sus principales limitaciones es su ventana de contexto limitada a 32K tokens, lo que puede afectar su capacidad para manejar tareas complejas que requieren largas secuencias de datos. Además, como otros modelos de IA desarrollados en China, QwQ-32B debe cumplir con los requisitos regulatorios locales, lo que puede restringir algunas de sus capacidades en temas políticamente sensibles.

Sin embargo, estos desafíos no restan mérito a los logros de QwQ-32B. De hecho, su lanzamiento marca un punto de inflexión en la industria, demostrando que la innovación en IA no depende exclusivamente del tamaño del modelo, sino de la creatividad y eficiencia en su diseño y entrenamiento.

IR A BIT2ME LIFELa inversión en criptoactivos no está totalmente regulada, puede no ser adecuada para inversores minoristas debido a su alta volatilidad y existe riesgo de perder la totalidad de los importes invertidos.